Flink_CDC构建流式ETL

作者: 罗宇侠(宇侠)

本篇教程将展示如何基于 Flink CDC 快速构建 MySQL 和 Postgres 的流式 ETL。

Flink-CDC 项目地址:

本教程的演示基于 Docker 环境,都将在 Flink SQL CLI 中进行,只涉及 SQL,无需一行 Java/Scala 代码,也无需安装 IDE。

假设我们正在经营电子商务业务,商品和订单的数据存储在 MySQL 中,订单对应的物流信息存储在 Postgres 中。

对于订单表,为了方便进行分析,我们希望让它关联上其对应的商品和物流信息,构成一张宽表,并且实时把它写到 ElasticSearch 中。

接下来的内容将介绍如何使用 Flink Mysql/Postgres CDC 来实现这个需求,系统的整体架构如下图所示:

一、准备阶段

准备一台已经安装了 Docker 的 Linux 或者 MacOS 电脑。

1.1 准备教程所需要的组件

接下来的教程将以 docker-compose 的方式准备所需要的组件。

使用下面的内容创建一个 docker-compose.yml 文件:

version: '2.1'services:postgres:image: debezium/example-postgres:1.1ports:- "5432:5432"environment:- POSTGRES_PASSWORD=1234- POSTGRES_DB=postgres- POSTGRES_USER=postgres- POSTGRES_PASSWORD=postgresmysql:image: debezium/example-mysql:1.1ports:- "3306:3306"environment:- MYSQL_ROOT_PASSWORD=123456- MYSQL_USER=mysqluser- MYSQL_PASSWORD=mysqlpwelasticsearch:image: elastic/elasticsearch:7.6.0environment:- cluster.name=docker-cluster- bootstrap.memory_lock=true- "ES_JAVA_OPTS=-Xms512m -Xmx512m"- discovery.type=single-nodeports:- "9200:9200"- "9300:9300"ulimits:memlock:soft: -1hard: -1nofile:soft: 65536hard: 65536kibana:image: elastic/kibana:7.6.0ports:- "5601:5601"

该 Docker Compose 中包含的容器有:

- MySQL:商品表

products和 订单表orders将存储在该数据库中, 这两张表将和 Postgres 数据库中的物流表shipments进行关联,得到一张包含更多信息的订单表enriched_orders; - Postgres:物流表

shipments将存储在该数据库中; - Elasticsearch:最终的订单表

enriched_orders将写到 Elasticsearch; - Kibana:用来可视化 ElasticSearch 的数据。

在 docker-compose.yml 所在目录下执行下面的命令来启动本教程需要的组件:

xxxxxxxxxxdocker-compose up -d

该命令将以 detached 模式自动启动 Docker Compose 配置中定义的所有容器。你可以通过 docker ps 来观察上述的容器是否正常启动了,也可以通过访问 http://localhost:5601/ 来查看 Kibana 是否运行正常。

注:本教程接下来用到的容器相关的命令也都需要在 docker-compose.yml 所在目录下执行。

1.2 下载 Flink 和所需要的依赖包

下载 Flink 1.13.2 [1] 并将其解压至目录

flink-1.13.2下载下面列出的依赖包,并将它们放到目录

flink-1.13.2/lib/下

[1] https://downloads.apache.org/flink/flink-1.13.2/flink-1.13.2-bin-scala_2.11.tgz

该链接无法下载,可以在这里下载: https://archive.apache.org/dist/flink/flink-1.13.2/

1.3 准备数据

1.3.1 在 MySQL 数据库中准备数据

进入 MySQL 容器:

xxxxxxxxxxdocker-compose exec mysql mysql -uroot -p123456创建数据库和表

products,orders,并插入数据:x-- MySQLCREATE DATABASE mydb;USE mydb;CREATE TABLE products (id INTEGER NOT NULL AUTO_INCREMENT PRIMARY KEY,name VARCHAR(255) NOT NULL,description VARCHAR(512));ALTER TABLE products AUTO_INCREMENT = 101;INSERT INTO productsVALUES (default,"scooter","Small 2-wheel scooter"),(default,"car battery","12V car battery"),(default,"12-pack drill bits","12-pack of drill bits with sizes ranging from #40 to #3"),(default,"hammer","12oz carpenter's hammer"),(default,"hammer","14oz carpenter's hammer"),(default,"hammer","16oz carpenter's hammer"),(default,"rocks","box of assorted rocks"),(default,"jacket","water resistent black wind breaker"),(default,"spare tire","24 inch spare tire");CREATE TABLE orders (order_id INTEGER NOT NULL AUTO_INCREMENT PRIMARY KEY,order_date DATETIME NOT NULL,customer_name VARCHAR(255) NOT NULL,price DECIMAL(10, 5) NOT NULL,product_id INTEGER NOT NULL,order_status BOOLEAN NOT NULL -- Whether order has been placed) AUTO_INCREMENT = 10001;INSERT INTO ordersVALUES (default, '2020-07-30 10:08:22', 'Jark', 50.50, 102, false),(default, '2020-07-30 10:11:09', 'Sally', 15.00, 105, false),(default, '2020-07-30 12:00:30', 'Edward', 25.25, 106, false);

1.3.2 在 Postgres 数据库中准备数据

进入 Postgres 容器:

xxxxxxxxxxdocker-compose exec postgres psql -h localhost -U postgres创建表

shipments,并插入数据:xxxxxxxxxx-- PGCREATE TABLE shipments (shipment_id SERIAL NOT NULL PRIMARY KEY,order_id SERIAL NOT NULL,origin VARCHAR(255) NOT NULL,destination VARCHAR(255) NOT NULL,is_arrived BOOLEAN NOT NULL);ALTER SEQUENCE public.shipments_shipment_id_seq RESTART WITH 1001;ALTER TABLE public.shipments REPLICA IDENTITY FULL;INSERT INTO shipmentsVALUES (default,10001,'Beijing','Shanghai',false),(default,10002,'Hangzhou','Shanghai',false),(default,10003,'Shanghai','Hangzhou',false);

二、启动 Flink 集群和 Flink SQL CLI

使用下面的命令跳转至 Flink 目录下:

xxxxxxxxxxcd flink-1.13.2使用下面的命令启动 Flink 集群:

xxxxxxxxxx./bin/start-cluster.sh启动成功的话,可以在 http://localhost:8081/ 访问到 Flink Web UI,如下所示:

使用下面的命令启动 Flink SQL CLI

xxxxxxxxxx./bin/sql-client.sh启动成功后,可以看到如下的页面:

三、在 Flink SQL CLI 中使用 Flink DDL 创建表

首先,开启 checkpoint,每隔 3 秒做一次 checkpoint。

xxxxxxxxxx-- Flink SQLFlink SQL> SET execution.checkpointing.interval = 3s;

然后, 对于数据库中的表 products, orders, shipments,使用 Flink SQL CLI 创建对应的表,用于同步这些底层数据库表的数据。

xxxxxxxxxx-- Flink SQLFlink SQL> CREATE TABLE products (id INT,name STRING,description STRING,PRIMARY KEY (id) NOT ENFORCED) WITH ('connector' = 'mysql-cdc','hostname' = 'localhost','port' = '3306','username' = 'root','password' = '123456','database-name' = 'mydb','table-name' = 'products');Flink SQL> CREATE TABLE orders (order_id INT,order_date TIMESTAMP(0),customer_name STRING,price DECIMAL(10, 5),product_id INT,order_status BOOLEAN,PRIMARY KEY (order_id) NOT ENFORCED) WITH ('connector' = 'mysql-cdc','hostname' = 'localhost','port' = '3306','username' = 'root','password' = '123456','database-name' = 'mydb','table-name' = 'orders');Flink SQL> CREATE TABLE shipments (shipment_id INT,order_id INT,origin STRING,destination STRING,is_arrived BOOLEAN,PRIMARY KEY (shipment_id) NOT ENFORCED) WITH ('connector' = 'postgres-cdc','hostname' = 'localhost','port' = '5432','username' = 'postgres','password' = 'postgres','database-name' = 'postgres','schema-name' = 'public','table-name' = 'shipments');

最后,创建 enriched_orders 表, 用来将关联后的订单数据写入 Elasticsearch 中。

xxxxxxxxxx-- Flink SQLFlink SQL> CREATE TABLE enriched_orders (order_id INT,order_date TIMESTAMP(0),customer_name STRING,price DECIMAL(10, 5),product_id INT,order_status BOOLEAN,product_name STRING,product_description STRING,shipment_id INT,origin STRING,destination STRING,is_arrived BOOLEAN,PRIMARY KEY (order_id) NOT ENFORCED) WITH ('connector' = 'elasticsearch-7','hosts' = 'http://localhost:9200','index' = 'enriched_orders');

四、关联订单数据并且将其写入 Elasticsearch 中

使用 Flink SQL 将订单表 order 与 商品表 products,物流信息表 shipments 关联,并将关联后的订单信息写入 Elasticsearch 中。

xxxxxxxxxx-- Flink SQLFlink SQL> INSERT INTO enriched_ordersSELECT o.*, p.name, p.description, s.shipment_id, s.origin, s.destination, s.is_arrivedFROM orders AS oLEFT JOIN products AS p ON o.product_id = p.idLEFT JOIN shipments AS s ON o.order_id = s.order_id;

启动成功后,可以访问 http://localhost:8081/#/job/running 在 Flink Web UI 上看到正在运行的 Flink Streaming Job,如下图所示:

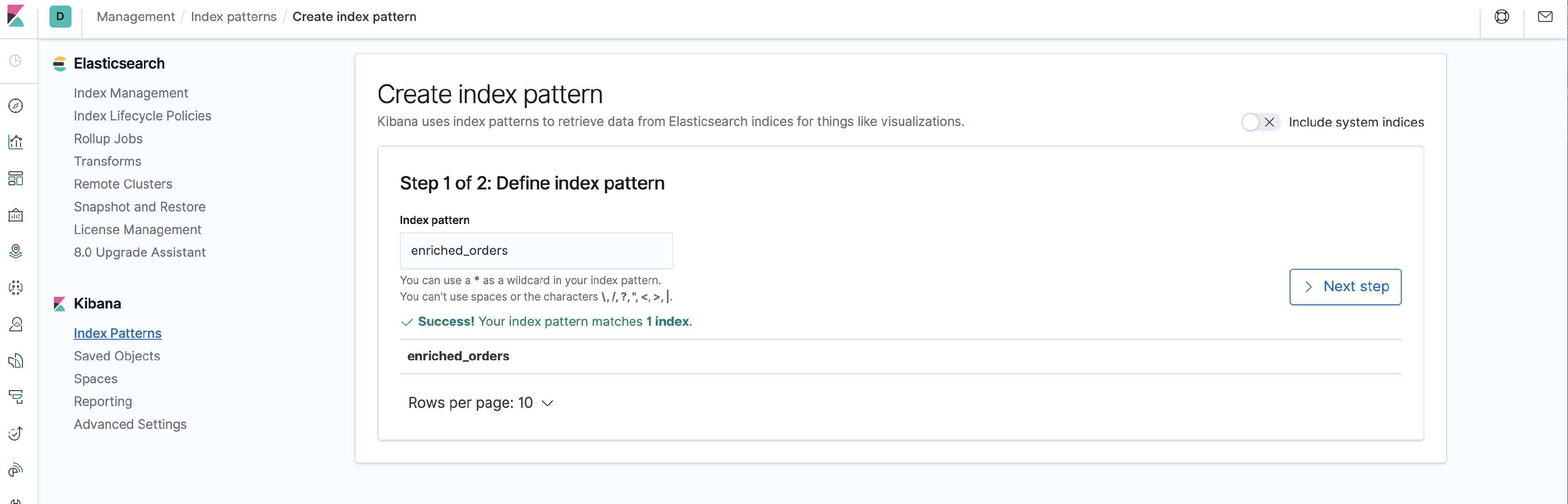

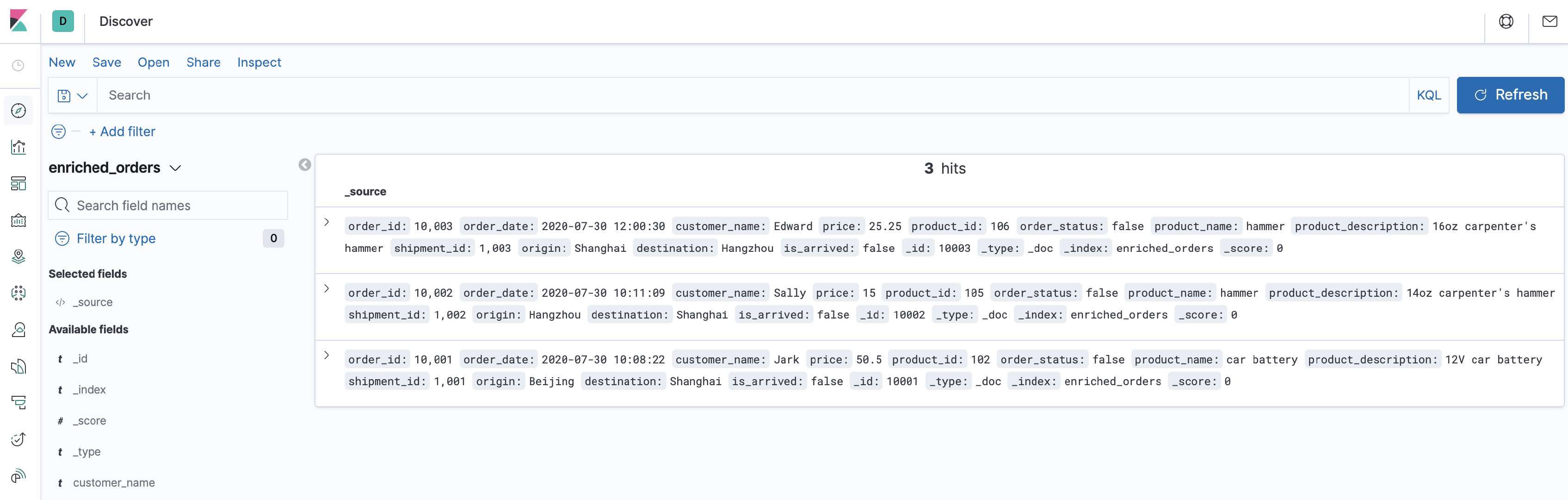

现在,就可以在 Kibana 中看到包含商品和物流信息的订单数据。

首先访问 http://localhost:5601/app/kibana#/management/kibana/index_pattern 创建 index pattern enriched_orders。

然后就可以在 http://localhost:5601/app/kibana#/discover 看到写入的数据了。

接下来,修改 MySQL 和 Postgres 数据库中表的数据,Kibana 中显示的订单数据也将实时更新。

在 MySQL 的

orders表中插入一条数据:xxxxxxxxxx--MySQLINSERT INTO ordersVALUES (default, '2020-07-30 15:22:00', 'Jark', 29.71, 104, false);-- kibana 新增了一条记录order_id:10,004 order_date:2020-07-30 15:22:00 customer_name:Jark price:29.71 product_id:104 order_status:false product_name:hammer product_description:12oz carpenter's hammer shipment_id: - origin: - destination: - is_arrived: - _id:10004 _type:_doc _index:enriched_orders _score:0在 Postgres 的

shipment表中插入一条数据:xxxxxxxxxx--PGINSERT INTO shipmentsVALUES (default,10004,'Shanghai','Beijing',false);-- kibana 更新了order_id:10,004 order_date:2020-07-30 15:22:00 customer_name:Jark price:29.71 product_id:104 order_status:false product_name:hammer product_description:12oz carpenter's hammer shipment_id:1,004 origin:Shanghai destination:Beijing is_arrived:false _id:10004 _type:_doc _index:enriched_orders _score:0在 MySQL 的

orders表中更新订单的状态:xxxxxxxxxx--MySQLUPDATE orders SET order_status = true WHERE order_id = 10004;-- kibana 更新了order_id:10,004 order_date:2020-07-30 15:22:00 customer_name:Jark price:29.71 product_id:104 order_status:true product_name:hammer product_description:12oz carpenter's hammer shipment_id:1,004 origin:Shanghai destination:Beijing is_arrived:false _id:10004 _type:_doc _index:enriched_orders _score:0在 Postgres 的

shipment表中更新物流的状态:xxxxxxxxxx--PGUPDATE shipments SET is_arrived = true WHERE shipment_id = 1004;-- kibana 更新了order_id:10,004 order_date:2020-07-30 15:22:00 customer_name:Jark price:29.71 product_id:104 order_status:true product_name:hammer product_description:12oz carpenter's hammer shipment_id:1,004 origin:Shanghai destination:Beijing is_arrived:true _id:10004 _type:_doc _index:enriched_orders _score:0在 MYSQL 的

orders表中删除一条数据:xxxxxxxxxx--MySQLDELETE FROM orders WHERE order_id = 10004;-- kibana 该条记录被删除了每执行一步就刷新一次 Kibana,可以看到 Kibana 中显示的订单数据将实时更新,如下所示:

五、环境清理

本教程结束后,在 docker-compose.yml 文件所在的目录下执行如下命令停止所有容器:

xxxxxxxxxxdocker-compose down

在 Flink 所在目录 flink-1.13.2 下执行如下命令停止 Flink 集群:

xxxxxxxxxx./bin/stop-cluster.sh

六、总结

在本文中,我们以一个简单的业务场景展示了如何使用 Flink CDC 快速构建 Streaming ETL。希望通过本文,能够帮助读者快速上手 Flink CDC ,也希望 Flink CDC 能满足你的业务需求。